Как использовать веб-скребок? • ТехРТ

В сегодняшнем цифровом мире данные имеют огромную ценность, и практика парсинга веб-страниц стала важнейшим методом для тех, кто стремится собирать информацию в Интернете. Использование парсера — типа программного обеспечения, предназначенного для автоматизации извлечения данных с веб-сайтов, — может значительно упростить этот процесс.

От сбора данных исследования рынка до мониторинга ценовой стратегии конкурентов или сопоставления новостного контента — эффективное применение парсера может стать мерой, позволяющей сэкономить время и получить ценную информацию.

Целью данного руководства является ознакомление вас с основными этапами использования скребка, выделение подходящих инструментов и решение различных проблем, с которыми вы можете столкнуться.

Что такое веб-скребки?

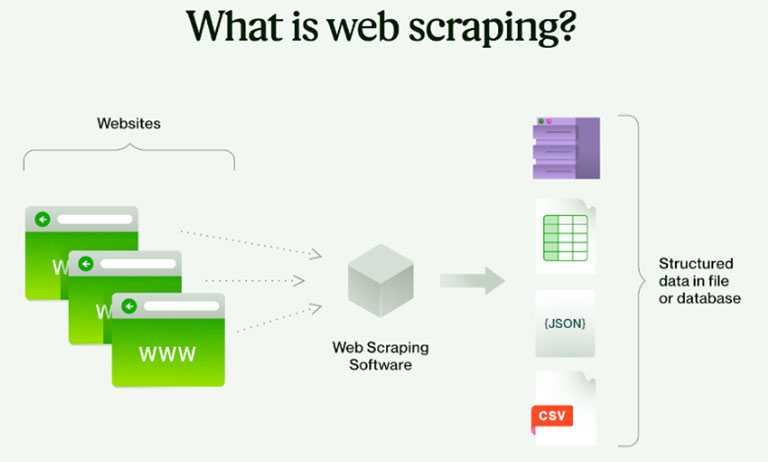

Веб-скрапер — это специализированный программный инструмент, предназначенный для автоматизации процесса извлечения данных с веб-сайтов. Он перемещается по сети, получает доступ к определенным страницам, а затем собирает необходимую информацию с этих сайтов. Это может варьироваться от текста и изображений до сложных структур данных, таких как списки продуктов, отзывы пользователей или даже публикации в социальных сетях. Обычно парсер идентифицирует и анализирует код HTML или XML веб-страниц для извлечения соответствующего контента.

Это мощный инструмент для предприятий, исследователей и частных лиц, которым необходимо эффективно собирать большие объемы онлайн-данных. Парсеры широко используются в различных приложениях, таких как исследования рынка, сравнение цен, генерация потенциальных клиентов и агрегирование контента. Их способность быстро и систематически собирать онлайн-информацию делает их бесценными в эпоху, когда данные являются важнейшим активом.

Выбор правильных инструментов: роль службы резидентных IP-прокси

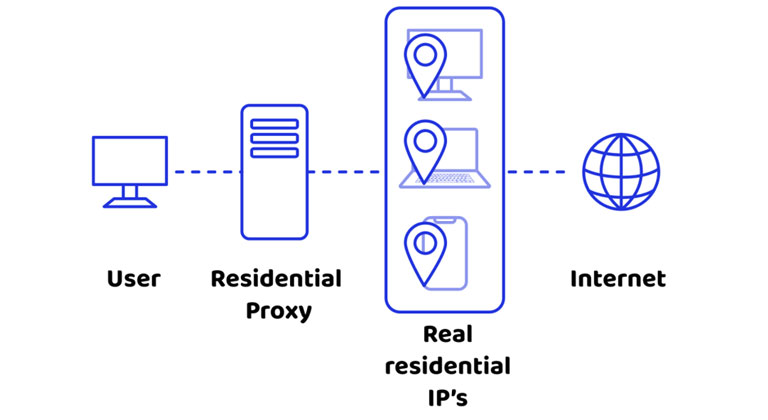

Первый шаг к эффективному парсингу веб-страниц — выбор правильных инструментов. Сюда входит как программное обеспечение для очистки, так и тип используемого вами прокси-сервиса. А услуга резидентного IP-прокси особенно важно при очистке данных. Эти службы предоставляют IP-адреса, которые связаны с физическим местоположением, благодаря чему ваши действия по сбору данных выглядят более органично и с меньшей вероятностью будут заблокированы веб-сайтами.

Резидентные прокси идеально подходят для обхода мер по защите от парсинга, поскольку они меняют IP-адреса, снижая риск обнаружения и блокировки IP-адресов. Это особенно важно при парсинге веб-сайтов со строгой политикой сбора данных или когда вам нужен доступ к контенту с географическим ограничением.

Настройка скребка

- Выберите инструмент для очистки: выберите инструмент для очистки, который соответствует вашему уровню технических навыков и сложности ваших потребностей в очистке. Доступны различные инструменты: от простых расширений для браузера до сложного программного обеспечения, такого как Octoparse или Scrapy.

- Определите свои требования к данным: четко определите, какие данные вам нужно очистить. Это могут быть цены на продукты, уровень запасов, текст статьи или публикации в социальных сетях. Точное знание того, что вам нужно, поможет вам более эффективно настроить парсер.

- Изучите основы HTML и CSS. Понимание основ HTML и CSS может быть невероятно полезным, поскольку позволит вам идентифицировать конкретные элементы веб-страницы, которые вы хотите очистить.

Настройка и запуск парсера

Настройка и эксплуатация парсера требует системного подхода для обеспечения эффективного и точного извлечения данных. Вот расширенное руководство о том, как эффективно настроить и запустить парсер.

Введите целевые URL-адреса

- Сбор URL-адресов. Начните со сбора URL-адресов веб-сайтов, с которых вам нужно собрать данные. Это может быть один веб-сайт или несколько сайтов, в зависимости от вашего проекта.

- Пакетная обработка. Многие продвинутые инструменты парсинга позволяют вводить список URL-адресов для пакетной обработки, что позволяет одновременно парсить несколько страниц. Эта функция особенно полезна для крупномасштабных проектов по извлечению данных.

Настройка правил извлечения данных

- Определите точки данных. Определите конкретные фрагменты информации, которые вам необходимо извлечь. Это может варьироваться от текста и изображений до информации о ценах и отзывов пользователей.

- Выбор элементов HTML. Используйте инструмент выбора парсера, чтобы точно определить элементы HTML, содержащие нужные данные. Это может потребовать некоторого количества проб и ошибок, чтобы убедиться, что вы захватываете правильный контент.

- Настройка шаблонов извлечения. Некоторые парсеры позволяют создавать собственные шаблоны извлечения или использовать регулярные выражения (regex) для более сложных структур данных.

Интеграция настроек прокси

- Выберите прокси-сервис. Выберите домашний IP-прокси-сервис, который предлагает пул IP-адресов для маскировки ваших действий по сбору данных.

- Настройте параметры прокси-сервера: введите данные вашего прокси-сервиса в парсер. Обычно это включает адрес прокси-сервера, номер порта и все необходимые данные аутентификации.

- Ротация IP-адресов. Убедитесь, что ваш прокси-сервис поддерживает ротацию IP-адресов, что имеет решающее значение для предотвращения обнаружения и блокировки IP-адресов во время сеансов очистки.

Запуск тестов

- Пилотное тестирование. Проведите пилотное тестирование, запустив парсер на небольшом наборе страниц. Это помогает выявить любые проблемы при извлечении или форматировании данных.

- Анализ результатов испытаний. Внимательно проверьте извлеченные данные на предмет точности и полноты. Проверьте, в правильном ли формате извлекаются данные и не упущена ли какая-либо важная информация.

- Настройте конфигурации: на основе результатов тестирования настройте параметры парсера. Это может включать настройку селекторов, изменение задержки между запросами или настройку параметров прокси.

Мониторинг и устранение неполадок

- Непрерывный мониторинг: как только вы начнете полномасштабную операцию очистки, постоянно отслеживайте процесс на предмет любых ошибок или блоков.

- Обработка капч и блоков. Реализуйте стратегии обработки капч и блокировки веб-сайтов, которые могут включать использование служб решения капч или корректировку частоты запросов.

- Проверка данных: регулярно проверяйте качество и актуальность собранных данных, гарантируя, что парсер продолжает работать должным образом.

Заключение

Парсинг веб-страниц с помощью парсера может стать мощным способом сбора данных из Интернета. Объединив правильный инструмент парсинга с надежным домашним IP-прокси-сервисом, вы сможете эффективно собирать необходимые данные, сводя при этом к минимуму риск обнаружения. Не забывайте всегда относиться к парсингу ответственно, соблюдая правовые и этические нормы, и будьте готовы к потенциальным проблемам, которые могут возникнуть в процессе парсинга.